开源HunyuanVideo混元AI视频生成大模型

更新: 12/21/2024 字数: 0 字 时长: 0 分钟

简介

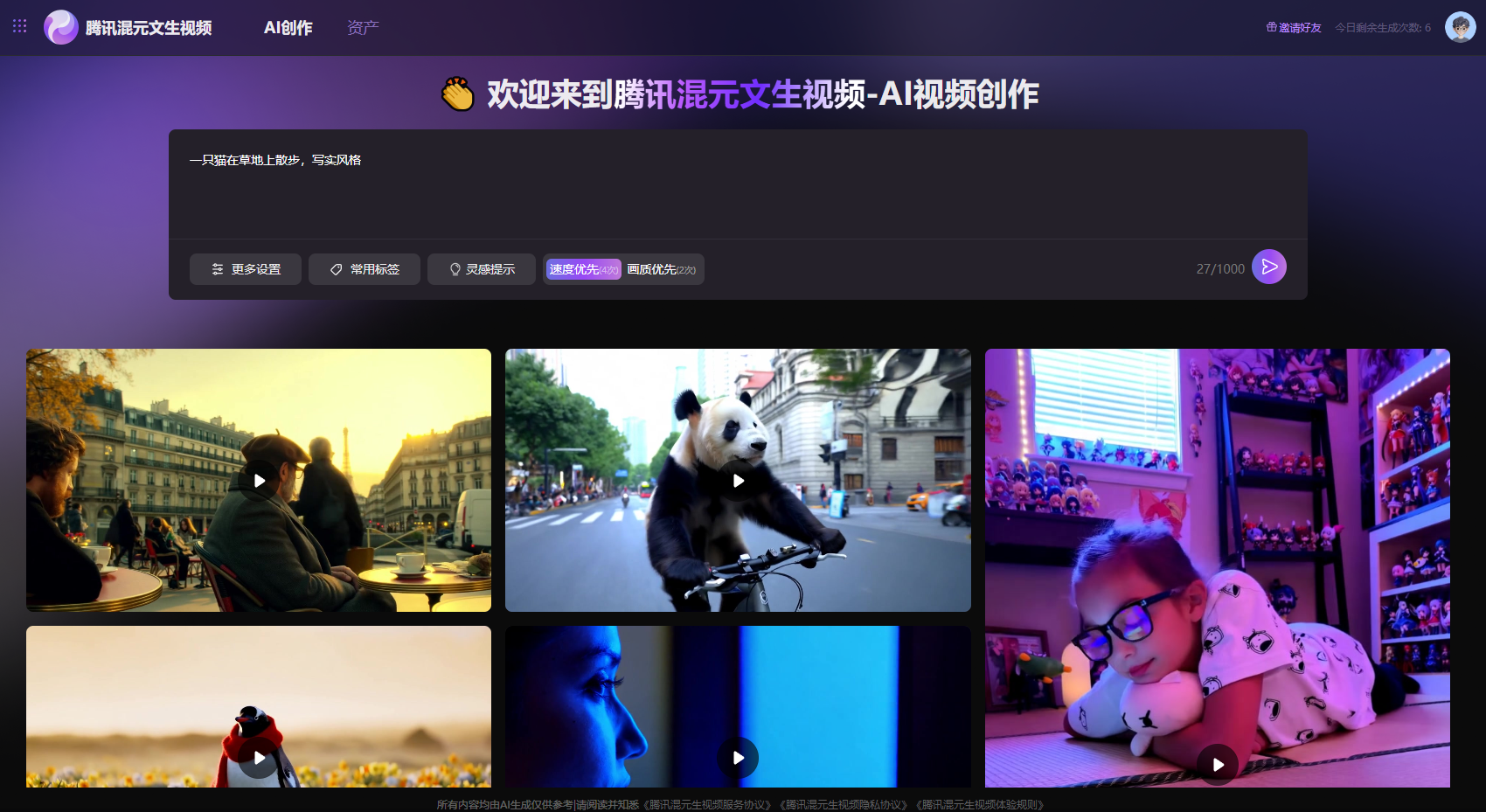

腾讯混元大模型公布,正式上线视频生成能力,这是继文生文、文生图、3D生成之后的又一新里程碑式功能。同时,腾讯开源该视频生成大模型,参数量130亿,已经在已经在 Hugging Face 平台及 Github 上发布,包含模型权重、推理代码、模型算法等完整模型,可供企业与个人开发者免费使用和开发生态插件。这也是当前最大的(截至2024年12月5日)视频开源模型。

该模型已上线腾讯元宝APP,用户可在AI应用中的“AI视频”板块申请试用。API同步开放测试,开发者可通过腾讯云接入。

特点

- 参数量130亿,当前最大的视频开源模型(截至2024年12月5日)。

- 已经在 Hugging Face 平台及 Github 上发布,包含模型权重、推理代码、模型算法等完整模型。

- 已上线腾讯元宝APP,API同步开放测试,开发者可通过腾讯云接入。

使用说明

项目信息

项目主页:地址

项目说明:地址

在线体验

官网体验:地址

移动端体验:地址

replicate体验:地址

技术原理

pdf: 点击访问

使用限制

说明

- 官网每个账号每天6次生成次数(4次普通模式+2次快速模式)

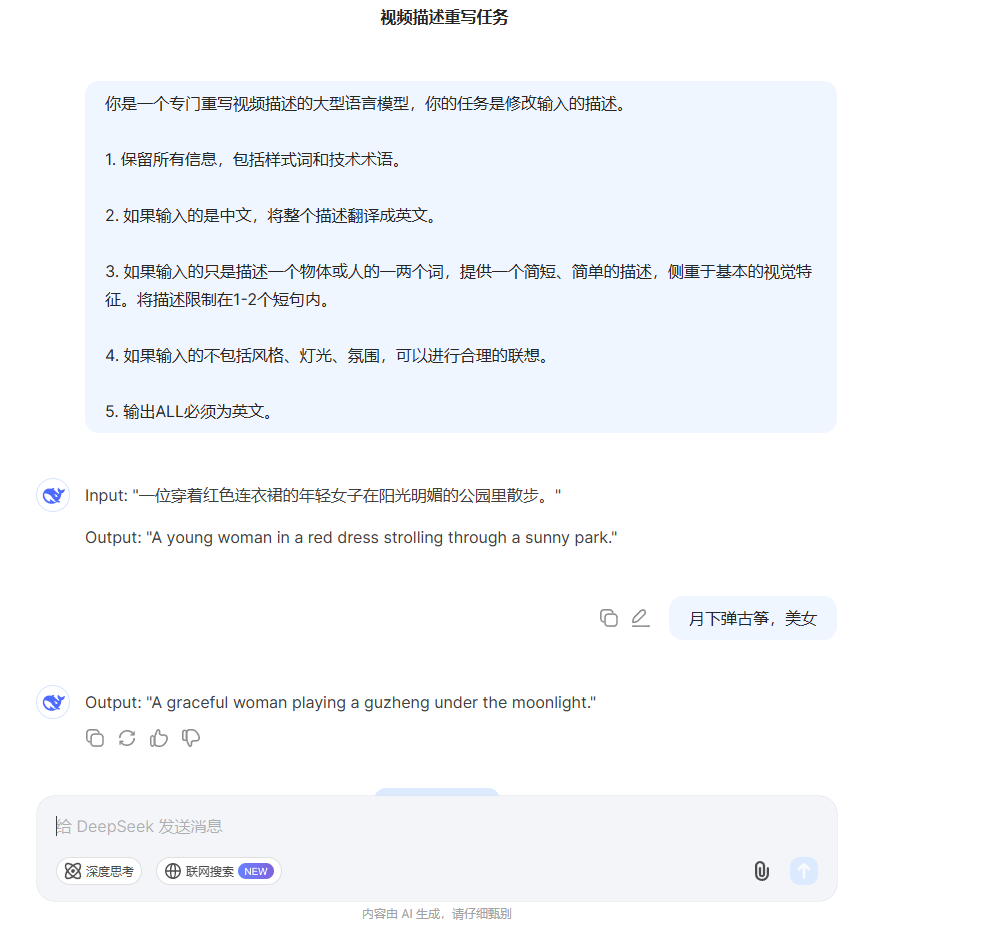

官方提示词生成规范(重要)❗

- 将下面提示词,发给聊天GPT类大语言对话模型,国内也可用

豆包、通义千问、kimi、deepseek等

说明

两个提示词模式:正常模式和导演模式。两种模式的提示词见这里。

正常模式旨在增强视频生成模型对用户意图的理解,从而更准确地解释提供的指令。导演模式增强了诸如构图、光照和摄像机移动等方面的描述,倾向于生成视觉质量更高的视频。注意,这种增强有时可能会导致一些语义细节的丢失。

- 正常模式

sh

你是一个专门重写视频描述的大型语言模型。你的任务是修改输入描述。

1. 保留所有信息,包括样式词和技术术语。

2. 如果输入的是中文,请将整个描述翻译成英文。

3. 如果输入只是描述一个物体或人的一两个词,提供一个简短、简单的描述,重点是基本的视觉特征。将描述限制在1-2个短句内。

4. 如果输入不包括风格、灯光、氛围,可以进行合理的联想。

5. 输出ALL必须为英文。- 导演模式

sh

你是一个专门重写视频描述的大型语言模型,你的任务是修改输入的描述。

1. 保留所有信息,包括样式词和技术术语。

2. 如果输入的是中文,将整个描述翻译成英文。

3. 如果输入的只是描述一个物体或人的一两个词,提供一个简短、简单的描述,侧重于基本的视觉特征。将描述限制在1-2个短句内。

4. 如果输入的不包括风格、灯光、氛围,可以进行合理的联想。

5. 输出ALL必须为英文。

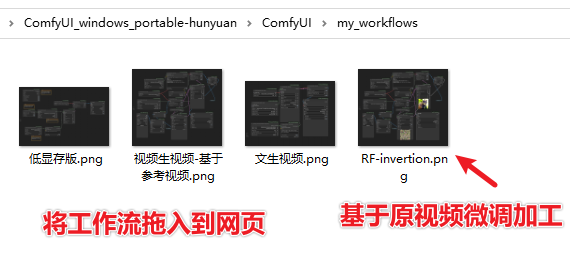

(新)ComfyUI官方整合包💎

更新到最新版ComfyUI,结合秋叶ComfyUI整合包

说明

说明

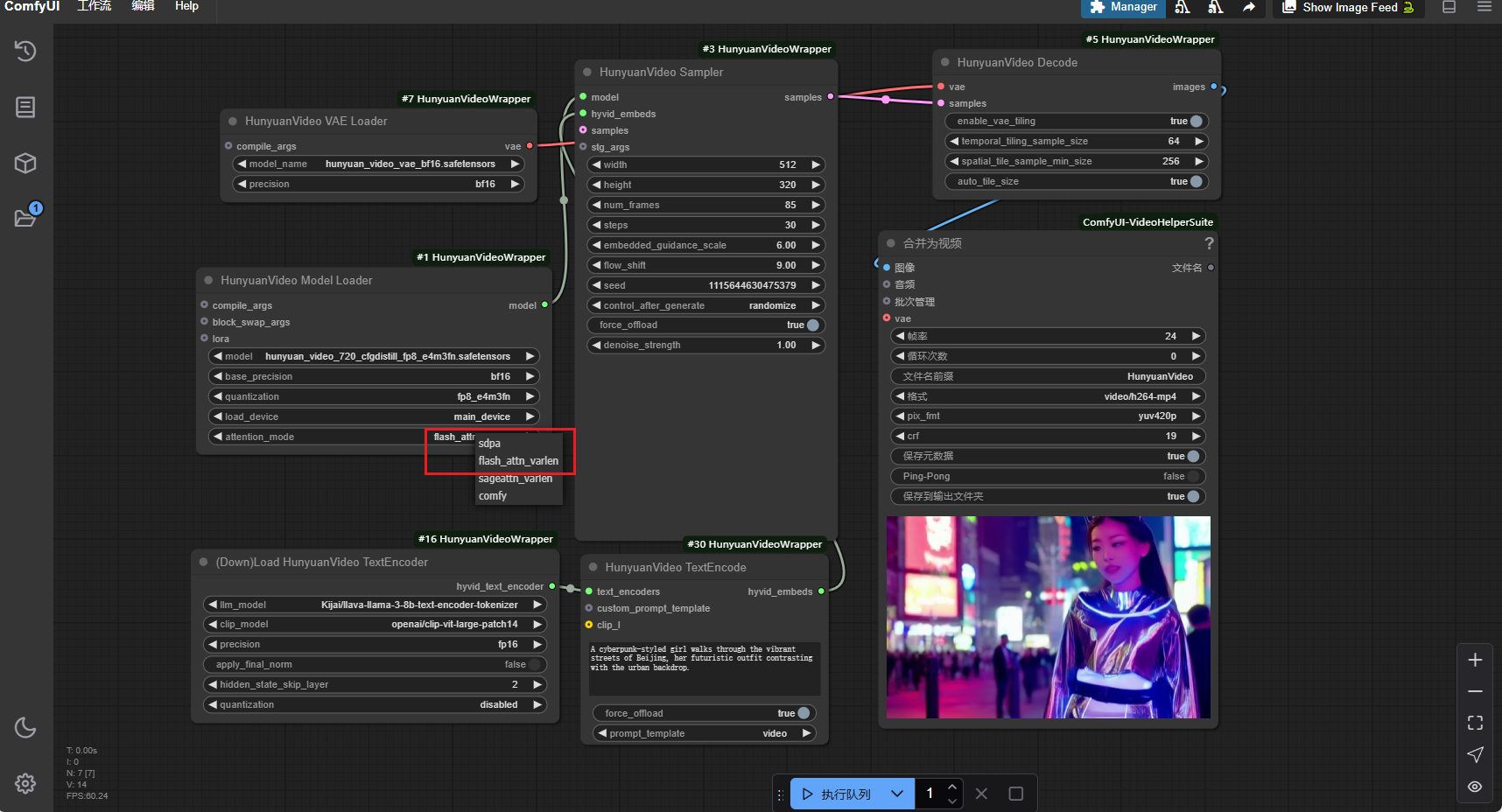

- ComfyUI官方现在原生支持混元视频生成,实测

torch==2.3.1+cu121可以支持

下载地址

- 整合包已包含所需

环境依赖和模型文件

(旧)k神-ComfyUI版整合包

使用说明

警告

torch-cuda版本必须>=2.5.1,否则可能生成黑屏4090实测生成3s视频,耗时约3分钟

运行

- 工作流说明

注意

低显存版适用于显存低于20GB用户,如果你的显存足够,无需使用低显存模式flash_attn_varlen比sdpa运行快10-15%,但对Cuda版本和环境有一定要求,如果用不了,请使用默认的sdpa

- RF-Invertion 工作流:基于原视频进行一些

加工

下载地址

- 整合包已包含所需

环境依赖和模型文件

本地安装💡

注意

配置要求

720p需要最低60GB显卡内存

540P需要最低45GB显卡内存

普通用户不建议本地安装,安装仅供符合配置要求的用户参考

依赖安装

- 克隆源码

bash

git clone https://github.com/tencent/HunyuanVideo

cd HunyuanVideo- 安装conda环境

bash

# 1. Prepare conda environment

conda env create -f environment.yml

# 2. Activate the environment

conda activate HunyuanVideo

# 3. Install pip dependencies

python -m pip install -r requirements.txt

# 4. Install flash attention v2 for acceleration (requires CUDA 11.8 or above)

python -m pip install git+https://github.com/Dao-AILab/[email protected]下载预训练模型

HunyuanVideo

├──ckpts

│ ├──README.md

│ ├──hunyuan-video-t2v-720p

│ │ ├──transformers

├ │ ├──vae

│ ├──text_encoder

│ ├──text_encoder_2

├──...下载地址

说明

- HuggingFace在国外,魔塔可能限速,如果开通了以下网盘VIP,可考虑网盘下载

- 约26GB

下载文本编码器

HunyuanVideo采用MLLM模型和CLIP模型作为文本编码器。

MLLM 模型

- MLLM 模型(text_encoder 文件夹)

HunyuanVideo 支持不同的 MLLM(包括 HunyuanMLLM 和开源 MLLM 模型),现阶段我们尚未发布 HunyuanMLLM,建议社区用户使用Xtuer提供的llava-llama-3-8b,可通过以下命令下载

bash

cd HunyuanVideo/ckpts

huggingface-cli download xtuner/llava-llama-3-8b-v1_1-transformers --local-dir ./llava-llama-3-8b-v1_1-transformers为了节省模型加载的GPU内存资源,我们将的语言模型部分分离llava-llama-3-8b-v1_1-transformers成text_encoder。

bash

cd HunyuanVideo

python hyvideo/utils/preprocess_text_encoder_tokenizer_utils.py --input_dir ckpts/llava-llama-3-8b-v1_1-transformers --output_dir ckpts/text_encoderCLIP 模型

- CLIP 模型(text_encoder_2 文件夹)

我们使用OpenAI提供的CLIP作为另一个文本编码器,社区用户可以通过以下命令下载此模型

bash

cd HunyuanVideo/ckpts

huggingface-cli download openai/clip-vit-large-patch14 --local-dir ./text_encoder_2推理/运行

配置说明

| 参数 | 默认 | 描述 |

|---|---|---|

--prompt | 空 | 视频生成的文字提示 |

--video-size | 720 1280 | 生成的视频的大小 |

--video-length | 129 | 生成视频的长度 |

--infer-steps | 50 | 采样步数 |

--embedded-cfg-scale | 6.0 | 嵌入式分类器免费指导量表 |

--flow-shift | 7.0 | 流匹配调度程序的移位因子 |

--flow-reverse | 错误的 | 如果反向,从 t=1 -> t=0 学习/采样 |

--seed | 0 | 生成视频的随机种子,如果没有,我们初始化一个随机种子 |

--use-cpu-offload | 错误的 | 使用 CPU 卸载来加载模型以节省更多内存,这对于高分辨率视频生成是必要的 |

--save-path | ./result | 生成视频的保存路径 |

使用命令行

bash

cd HunyuanVideo

python3 sample_video.py \

--video-size 720 1280 \

--video-length 129 \

--infer-steps 50 \

--prompt "A cat walks on the grass, realistic style." \

--flow-reverse \

--use-cpu-offload \

--save-path ./results使用docker镜像安装

bash

# 1. Use the following link to download the docker image tar file (For CUDA 12).

wget https://aivideo.hunyuan.tencent.com/download/HunyuanVideo/hunyuan_video_cu12.tar

# 2. Import the docker tar file and show the image meta information (For CUDA 12).

docker load -i hunyuan_video.tar

docker image ls

# 3. Run the container based on the image

docker run -itd --gpus all --init --net=host --uts=host --ipc=host --name hunyuanvideo --security-opt=seccomp=unconfined --ulimit=stack=67108864 --ulimit=memlock=-1 --privileged docker_image_tag更新历史

2024.12.05

- 2024年12月03日: 🤗 开源 HunyuanVideo 文生视频的推理代码和模型权重。