Flux版本说明和下载

更新: 12/21/2024 字数: 0 字 时长: 0 分钟

Huggingface访问

说明

- 以下

https://huggingface.co(抱抱脸)地址,需要科学上网,如果打不开,可以尝试使用镜像https://hf-mirror.com - 例如:

- Unet版和Checkpoint版区别:

- Unet版通俗来讲,没有包含

clip和vae,需要单独下载 - Checkpoint版,包含

clip和vae

- Unet版通俗来讲,没有包含

版本区别说明及下载

Pro版

效果最好,但是

闭源,API收费。

Dev版

开源但是

不可商用,至少需要24G显存运行。

官方全量版

- 模型下载:地址

FP8-checkpoint版

Comfyui官方推出的3合1版本,大概17G,模型已经集成Clip,直接使用checkpoints加载器就可以使用- 模型下载:地址

FP8-unet版✅

- KJ大佬制作的

11G左右的模型,需要单独两个Clip模型和Vae使用- 模型下载:Kijai/flux-fp8

低显存dev-gguf版 🚀

最适合低显存的模型,有 11 个版本,推荐Q4,Q8 版本的

Schnell版本

开源

可商用

官方版

- 模型下载:地址

FP8-checkpoint版

Comfyui官方推出Schnell3合1版本,大概17G,模型已经集成Clip,直接使用checkpoints加载器就可以使用

GGUF版

Flux-NF4 版本(弃用)⛔

集成了Clip模型,有分V1,V2 版本,推荐使用V2,而且需要配合插件使用

Clip

正常版

- 下载地址:地址

GGUF低显存版

需使用DualCLIPLoaderGGUF的节点:

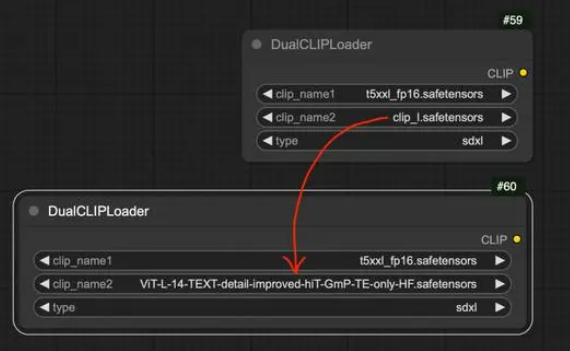

优化版

zer0int发布优化版

CLIP-GmP-ViT-L-14模型,支持FLUX模型,提升图像细节表现。

- 模型地址:地址

LongClip版

LongCLIP模型,适用于长文本提示。

- 模型地址:地址

Flux不同显存适用模型

由于使用

fp16生图不太实际,很快地就出现了Dev与Schnell的fp8版本。如果有

12GB以上的VRAM,Dev-FP8版本是一个可以考虑的选项,虽然相对耗时但效果更好。

说明

- 如果你的

4090可运行全精度DEV版本,但仍然建议常备一个GGUF8模型,因为后续工作流增加LORA和Controlnet所需的显存会更大 - 如果只有

6G显存则建议使用GGUF-4模型,12G以上显存可尝试GGUF-6/8模型。

- 后缀

_1、后缀·_K比后缀_0精度更高一点,当然相对应的显存也会占用更高一些。 - 另外,

Q8版本比官方的FP8更精确

实测执行记录

- 以下结果以

4090生成,仅供参考 - 大模型运行时会尽可能使用更多内存 ,不代表

小于峰值内存不能运行,运行和速度由实际显卡速度决定

| 版本 | 峰值内存 | 耗时(1张图) |

|---|---|---|

| flux1-dev-Q2_K.gguf+小红书lora | 11GB | 28.33 seconds |

| flux1-dev-Q3_K_S.gguf+小红书lora | 12.7GB | 33.49 seconds |

| flux1-dev-Q5_1.gguf+小红书lora | 15.2GB | 38.03 seconds |

| flux1-dev-Q8_0.gguf+小红书lora | 21.2GB | 28.58 seconds |