LivePortrait免安装版整合包

更新: 12/21/2024 字数: 0 字 时长: 0 分钟

概述

LivePortrait是由快手科技、中国科学技术大学和复旦大学合作开发的人工智能人像视频生成框架,能够将静态图片转化为带有真实面部表情和运动的动画视频。它利用先进的重演技术,通过驱动视频、音频或文本来模拟图像中的面部运动和表情。

功能

- 高精度肖像动画:LivePortrait能够将静态人像照片转化为逼真且动态的面部动画,模拟面部表情和头部运动。

- **风格多样化:**LivePortrait支持多种风格的人像动画,包括现实风格、油画、雕塑、3D渲染等。

- **眼睛和唇部重定向:**LivePortrait允许用户根据需要调整眼睛和嘴唇的张开程度,以匹配语音或表情。

- 支持动物动画:LivePortrait通过微调模型,可实现猫、狗、熊猫等动物的精准动画生成。

- 生成速度快:在RTX 4090 GPU上,每帧生成速度达到12.8毫秒,确保实时应用的流畅体验。

- 开源代码:LivePortrait的推理代码和模型在GitHub上公开,便于研究和进一步开发。

项目简介

项目信息

项目主页:Github

项目说明:地址

在线体验

HuggingFace体验:地址

Paper

手动安装

bash

git clone https://github.com/KwaiVGI/LivePortrait

cd LivePortrait

# create env using conda

conda create -n LivePortrait python=3.10

conda activate LivePortrait1

2

3

4

5

6

2

3

4

5

6

- X-Pose要求pytorch与CUDA版本兼容。首先,通过以下方式检查当前的CUDA版本:

bash

nvcc -V # example versions: 11.1, 11.8, 12.1, etc.1

- 然后,安装相应版本的pytorch。以下是不同CUDA版本的示例。如果您的CUDA版本未列出,请访问PyTorch官方网站获取安装命令:

bash

# for CUDA 11.1

pip install torch==1.10.1+cu111 torchvision==0.11.2 torchaudio==0.10.1 -f https://download.pytorch.org/whl/cu111/torch_stable.html

# for CUDA 11.8

pip install torch==2.3.0 torchvision==0.18.0 torchaudio==2.3.0 --index-url https://download.pytorch.org/whl/cu118

# for CUDA 12.1

pip install torch==2.3.0 torchvision==0.18.0 torchaudio==2.3.0 --index-url https://download.pytorch.org/whl/cu121

# ...1

2

3

4

5

6

7

2

3

4

5

6

7

- 注意:在Windows系统上,一些更高版本的CUDA(如

12.4,12.6等)可能会导致未知问题。为了稳定起见,您可以考虑将CUDA降级到11.8版本。

windows/Linux下安装

bash

pip install -r requirements.txt1

苹果芯片Silicon系统安装

bash

# for macOS with Apple Silicon users

pip install -r requirements_macOS.txt1

2

2

安装权重模型

bash

# !pip install -U "huggingface_hub[cli]"

huggingface-cli download KwaiVGI/LivePortrait --local-dir pretrained_weights --exclude "*.git*" "README.md" "docs"1

2

2

- 下载太慢,可以使用hf-mirror镜像

bash

# !pip install -U "huggingface_hub[cli]"

export HF_ENDPOINT=https://hf-mirror.com

huggingface-cli download KwaiVGI/LivePortrait --local-dir pretrained_weights --exclude "*.git*" "README.md" "docs"1

2

3

2

3

推理/运行

- 快速运行(人类)

bash

# For Linux and Windows users

python inference.py

# 适用于使用苹果芯片的macOS用户(英特尔未测试)。注意:这可能比RTX 4090慢20倍

PYTORCH_ENABLE_MPS_FALLBACK=1 python inference.py1

2

3

4

5

2

3

4

5

- 指定

-s或-d参数

bash

# 处理指定图片

python inference.py -s assets/examples/source/s9.jpg -d assets/examples/driving/d0.mp4

# 处理指定视频 ✨

python inference.py -s assets/examples/source/s13.mp4 -d assets/examples/driving/d0.mp4

# more options to see

python inference.py -h1

2

3

4

5

6

7

8

2

3

4

5

6

7

8

- 快速运行(动物)

动物模式只测试在Linux和Windows与NVIDIA GPU。

需要首先构建一个名为MultiScaleDeformableAttention的OP,它被X-Pose使用,这是一个通用的关键点检测框架

bash

cd src/utils/dependencies/XPose/models/UniPose/ops

python setup.py build install

cd - # equal to cd ../../../../../../../1

2

3

2

3

bash

python inference_animals.py -s assets/examples/source/s39.jpg -d assets/examples/driving/wink.pkl --driving_multiplier 1.75 --no_flag_stitching1

- 驱动视频自动裁剪

注意

要使用您自己的驱动视频,我们建议:

- ⬇️裁剪为1:1的宽高比(例如,512x512或256x256像素),或启用自动裁剪——flag

--flag_crop_driving_video。 - 关注头部区域,类似于示例视频。

- 尽量减少肩部活动。

- 确保驱动视频的第一帧是正面,表情中立。

- 下面是一个

自动裁剪的例子 - 如果发现自动裁剪的结果不太好,可以修改

--scale_crop_driving_video和--vy_ratio_crop_driving_video选项调整比例和偏移量,或手动进行。

bash

python inference.py -s assets/examples/source/s9.jpg -d assets/examples/driving/d13.mp4 --flag_crop_driving_video1

运动模板制作

你也可以使用以

.pkl结尾的自动生成的动作模板文件来加速推理,并保护隐私,例如:

bash

python inference.py -s assets/examples/source/s9.jpg -d assets/examples/driving/d5.pkl # portrait animation

python inference.py -s assets/examples/source/s13.mp4 -d assets/examples/driving/d5.pkl # portrait video editing1

2

2

使用Gradio

bash

# 适用于Linux和Windows用户(以及带有英特尔的macOS ??)

python app.py # humans mode

# 对于苹果芯片用户的macOS,英特尔不支持,这可能比RTX 4090慢20倍

PYTORCH_ENABLE_MPS_FALLBACK=1 python app.py # humans mode1

2

3

4

5

2

3

4

5

- 动物模式的梯度接口,仅在Linux上使用NVIDIA GPU进行测试

bash

python app_animals.py # animals mode 🐱🐶1

- 可以指定

--server_port、--share、--server_name参数来满足您的需求! - 🚀 我们还提供加速选项

flag_do_torch_compile。第一次推理触发最优化的过程(大约一分钟),使后续推理速度提高20-30%。性能提升可能因CUDA版本而异。 - 注意:

Windows和macOS不支持此方法。

bash

# 启用torch. compile以实现更快的推理

python app.py --flag_do_torch_compile1

2

2

推理速度评估

我们还提供了一个脚本来评估每个模块的推理速度:

bash

# NVIDIA GPU

python speed.py1

2

2

万能君exe+webui免安装版💎

注意

解压后,路径不要含有中文,路径不要含有中文,路径不要含有中文

下载说明

- 软件已经过测试,测试平台为

Windows10和Nvidia-4090显卡 - 不支持

AMD显卡及核显,显存尽量12GB以上,cuda-12版本,低显存或低cuda版本不保证正常使用 - 点此查看自己的显卡相关信息

- 压缩包已包含依赖的环境模型等大文件,无需安装环境,点开即用;

下载地址

使用注意事项

使用注意**:

主要功能是

表情迁移,动作不要有大幅度晃头,歪头,转头,侧脸等动作演示驱动视频由于人脸忽远忽近,会导致生成的视频受影响

尽量保证源图片或视频,与驱动的图片或视频,

人脸角度一致

webui界面功能说明

![图片[2]-LivePortrait-v20240829-webui免安装环境版-AI - The Next generation](/d2b5ca33bd20241126050115-1024x765.png)

编辑人像

![图片[4]-LivePortrait-v20240829-webui免安装环境版-AI - The Next generation](/d2b5ca33bd20241126042149-1024x834.png)

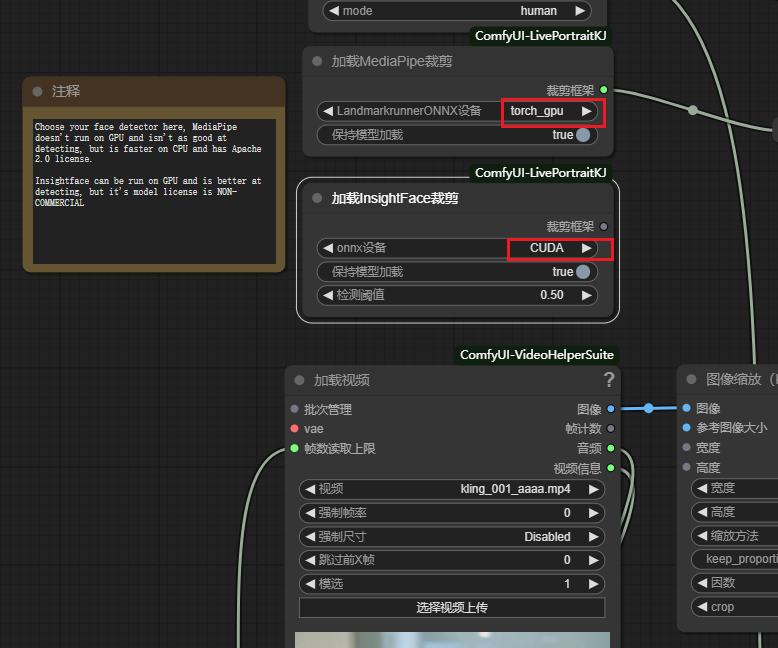

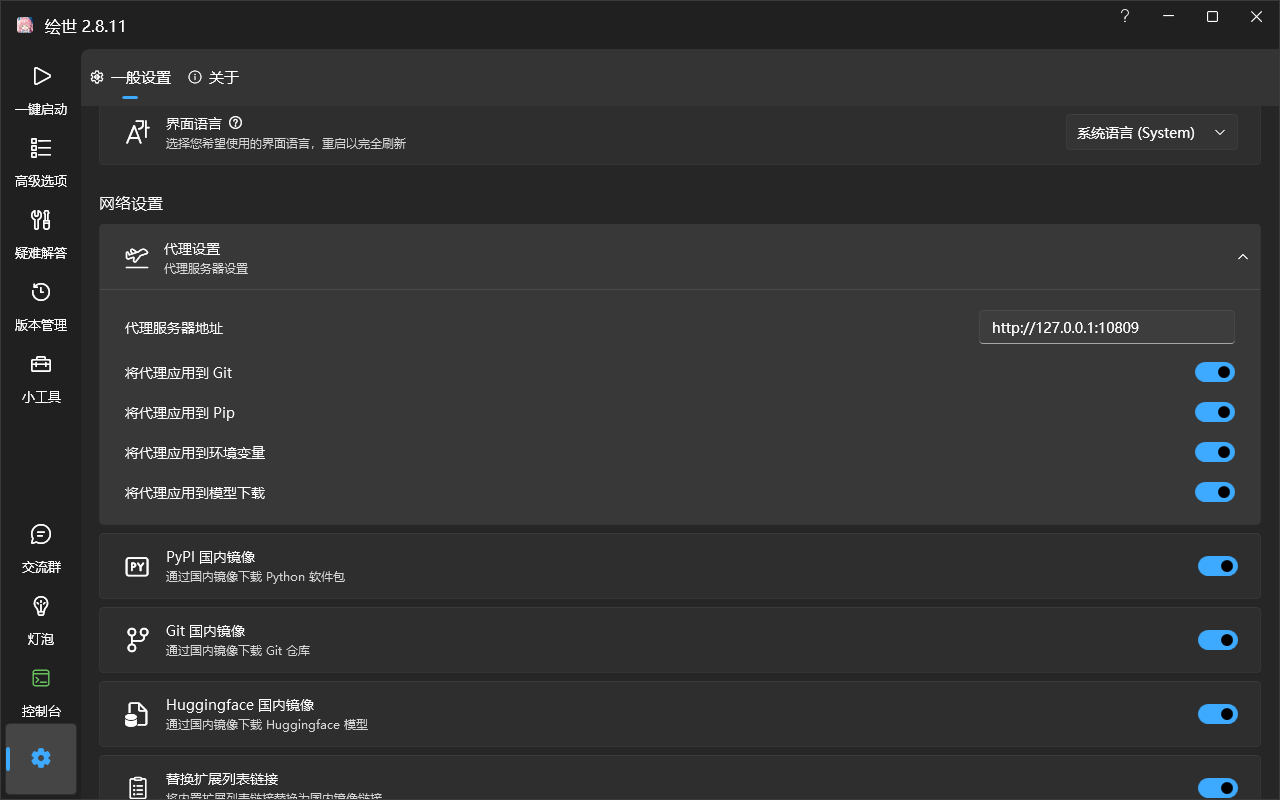

秋叶ComfUI免安装版🔑

- 秋叶ComfyUI基础教程:查看

- 开启科学上网,注意,打开代理网络设置,然后

重启comfyUI

安装教程

注意

- 下面两种安装说明和教程

只为记录过程, - 直接从下载地址的

网盘下载启动包和模型文件,启动即可,无需再次安装

使用安装管理器方式

- 安装成功后,重启

ComfyUI

使用git仓库手动方式

- 如果安装管理安装有问题,可以使用手动方式

- 克隆仓库

bash

# 进入comfyUI节点目录

cd custom_nodes

git clone https://github.com/smthemex/ComfyUI-LivePortraitKJ

cd ComfyUI-LivePortraitKJ1

2

3

4

5

6

2

3

4

5

6

- 使用

当前ComyUI环境的python进行安装(注意:不要直接使用python.exe)

bash

# 当前ComfyUI环境的python

..\..\python\python.exe -m pip install -r requirements.txt1

2

2

下载地址

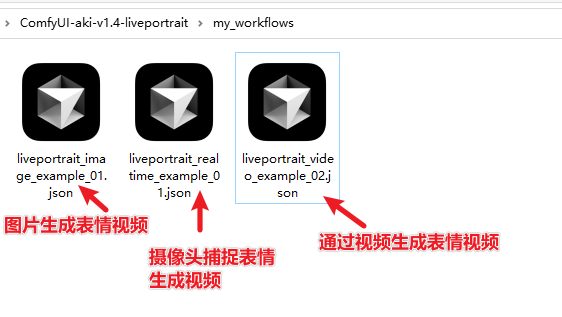

运行

- 工作流说明

- 启用

GPU